基于听损分类的助听器语音质量自评价方法

1.本发明涉及助听器语音质量评价技术领域,特别涉及基于听损分类的助听器语音质量自评价方法。

背景技术:

2.传统助听器主要通过放大声信号来补偿患者缺失的声波能量和频率成分,并依靠验配师的经验和专业技能来调配算法参数以尽可能达到最佳的工作状态。但这种助听器验配方式效率较低且难以有效传承,具有较大的局限性。免验配助听器是未来助听器的一大发展趋势,其能根据患者听力损失情况,初步进行验配操作,再通过语音质量自评价方法,更新算法参数,直至语音质量评价达到标准或患者自身满意为止。

3.语音质量评价的方法根据评价主体不同可分为主观评价法与客观评价法。主观评价法指在一定条件下以人为主体,依照标准语音对失真语音进行质量等级划分。常见的主观评价方法包括平均意见分(mos)、诊断押韵测试(drt)、满意度测量(dam)等。考虑到人是语音质量评价的最终接受者,主观评价法是语音质量评价最直接最准确的方法,被称为质量评价的“金标准”。但主观评价法由于要严格控制测试环境,同时聘请测评人,对时间金钱以及人力要求较高,难以在日常生活中进行。

4.客观评价法通过计算机模拟人耳的听觉过程,给出与主观评级高度相关的质量评级。根据是否需要原始参考信号,语音质量客观评价模型可分为“全参考式”和“无参考式”。全参考语音质量评价算法需同时提供作为参考的原始纯净信号和待评估的失真信号,国际电信联盟(itu)标准化的感知客观语音质量评估(poloa)是在电信领域广泛使用的一种全参考语音质量算法。在助听器语音质量领域,助听器语音质量指数(hasqi)和感受模型-听力障碍语音质量(pemo-q-hi)是两种典型的结合听障患者耳蜗受损情况而建立的全参考语音质量评价模型。尽管全参考语音质量评价算法与主观评级的相关性较高,但纯净的参考信号往往难以获取,极大地限制了它的应用范围。无参考语音质量评价算法不需要原始信号作为参考,直接从失真信号中提取特征参数,并利用先验知识或训练好的模型将其映射成质量评分。在电信领域,无参考语音质量评价模型已有较多研究,如itu标准p.563;低复杂度质量评估技术(lcqa);随着深度学习的发展,近些年一些基于深度学习的无参考语音质量评价方法也被提出,如qualitynet、nisqa、mosnet等。在助听器质量领域,现有的研究基本上都是对电信领域无参考模型的扩充,如lcqa-ha、srmr-ha。专门为助听器提出的无参考语音质量指标有plp-hl和fbe-hl。无参考质量评估方法的灵活性更强,但由于缺乏参考,其准确度相对较低,有待进一步改进和提高。

技术实现要素:

5.针对现有技术中无参考的助听器语音质量客观评价方法准确度不高的缺陷,本发明公开了基于听损分类的助听器语音质量自评价方法,使用多任务训练思路,以质量预测为主任务,以听损分类为辅任务,通过权重因子调节主、辅任务在网络中的重要程度,充分

利用卷积神经网络的特征提取能力,结合注意力机制的循环神经网络的时序建模能力,softmax函数的分类能力,发挥了不同网络模型的优势,提高无参考语音质量客观评价方法准确度,简化了助听器语音质量自评价的处理过程。

6.为解决上述技术问题,本发明提供了基于听损分类的助听器语音质量自评价方法,包括如下步骤:

7.s1:构建包括帧级特征提取网络、听损分类子网络、质量预测子网络的助听器语音质量自评价网络;

8.s2:将待测语音的浅层特征输入至帧级特征提取网络中,从而获得帧级特征;

9.s3:将获得的帧级特征输入至听损分类子网络中,得到失真语音补偿前听力损失程度的分类情况;

10.s4:将获得的帧级特征同时输入至质量预测子网络中,得到质量评分的预测值;

11.s5:助听器语音质量自评价网络利用助听器语音质量指标为标签的训练数据进行训练,损失函数由质量预测子网络和听损分类子网络的损失函数加权组合而成。

12.优选的,s2中将待测语音的浅层特征输入至帧级特征提取网络中,从而获得帧级特征,具体过程为:

13.基于助听器处理后信号计算浅层特征,利用帧级特征提取网络学习失真信号的深层表示,从而获得帧级特征,其中帧级特征提取网络由卷积神经网络构成。

14.优选的,s2具体过程中基于助听器处理后信号计算浅层特征为:

[0015][0016]

该特征表示各帧在gammatone滤波器各通道内的平均滤波器组能量,其中s表示失真信号经分帧加窗后在听觉频率尺度上的短时对数幅度谱,c、t、n分别为gammantone滤波器组的通道数c、帧数t、帧长n,最终失真信号浅层特征的形状为t

×

32。

[0017]

优选的,用于帧级特征提取网络的卷积神经网络由4组卷积网络堆叠而成,其中每组卷积网络依次包含一个二维卷积层,一个批标准化层和一个prelu激活函数层;各组二维卷积层的输出特征数依次为8、8、16、16,卷积核大小依次为[5,5]、[5,5]、[3,5]、[3,5],卷积步长依次为[1,1]、[1,2]、[1,2]、[1,2],填充宽度依次为[2,2]、[2,2]、[1,2]、[1,2];失真信号的浅层特征经卷积神经网络提取出的帧级特征形状表示为16

×

t

×

4,其中t为帧数t。

[0018]

优选的,s3中将获得的帧级特征输入至听损分类子网络中,得到失真语音补偿前听力损失程度的分类情况,过程为:

[0019]

将形状重置后的帧级特征先进行全局平均得到段级特征,然后通过一组经过批标准化后的全连接层和softmax层,得到失真语音补偿前听力损失程度的分类情况,其中听损分类子网络由一组经过批标准化后的全连接层和softmax层构成。

[0020]

优选的,s3中将获得的帧级特征输入至听损分类子网络中,得到失真语音补偿前听力损失程度的分类情况,具体过程为:

[0021]

s31:将提取出的帧级特征先进行形状重置,生成t

×

64的特征,其中t为帧数t,再将形状重置后的帧级特征进行全局平均,达到段级特征;

[0022]

s32:将段级特征输入至听损分类子网络的两个全连接层,其中听损分类子网络由

两个全连接层和一个softmax层堆叠而成,每个全连接层的输出都经过一个批标准化层,其中第一个批标准化层的输出经relu函数激活后送入第二个全连接层,第二个批标准化层的输出作为两个全连接层的最终输出被送入softmax层;段级特征经过两个全连接层的最终输出是长度为n

l

的向量,n

l

表示听损程度的总分类个数;

[0023]

s33:将两个全连接层的最终输出送入softmax层:两个全连接层输出的是长度为n

l

的向量,经softmax层给出了失真语音补偿前听力损失程度的分类情况,具体表示为:

[0024][0025]

式中表示送入softmax层的语音特征,下标i表示听损程度分类的级别,i∈{1,2,...,n

l

},oi(z)表示针对输入的语音特征softmax层对每一个听损程度分类的预测概率。

[0026]

优选的,s4中将获得的帧级特征同时输入至质量预测子网络中,得到质量评分的预测值,过程为:

[0027]

将形状重置后的帧级特征先通过结合自注意力机制的循环神经网络得到段级特征,这个段级特征再通过一个全连接层映射得到质量评分的预测值,其中质量预测子网络由循环神经网络、注意力机制层和一个经过激活的全连接层构成。

[0028]

优选的,s4中将获得的帧级特征同时输入至质量预测子网络中,得到质量评分的预测值,具体过程为:

[0029]

s41、将帧级特征进行形状重置,生成t

×

64的帧级特征,其中t为帧数t;

[0030]

s42、形状重置后的帧级特征送入结合注意力机制的循环神经网络得到段级特征:采用bilstm学习时序数据的双向依赖性,采用注意力机制补偿bilstm输出的隐层状态中可能存在的信息损失;

[0031]

s43、结合注意力机制的循环神经网络输出的段级特征送入全连接层映射得到质量评分的预测值,段级特征通过该全连接层后经sigmoid函数激活后给出最终预测的质量分数。

[0032]

优选的,其中bilstm的输入特征维数和隐层状态维数都设定为64,则输出特征位t

×

64,注意力机制对bilstm双向输出的各时间步都计算经注意力权重向量加权后的隐层状态输出,前向传播的第t个时间步时,注意力机制对其的输出为:

[0033][0034]

式中,m表示当前时间步,为第i时间步的隐藏输出列向量,上标f表示正向计算,表示第i的时间步对当前时间步m的注意力权重向量,计算如下:

[0035][0036]

式中wa为可学习的权重矩阵,m为时间步的个数,上标t表示矩阵转置;最终结合注意力机制的循环神经网络输出的段级特征是一个长度为128点的向量。

[0037]

优选的,s5中利用助听器语音质量指标为标签的训练数据进行训练的具体过程为:

[0038]

在训练过程中计算语音质量自评估网络的损失函数,直至损失函数值小于阈值完成训练;所述语音质量自评估网络的损失函数由质量预测子网络和听损分类子网络的损失函数加权组合而成,权重因子β调节听损分类子网络在语音质量自评价网络中的重要性程度:

[0039]

loss=(1-β)loss

score

+βloss

level

[0040]

其中,loss

score

表示质量预测子网络的损失函数,具体表示为:

[0041][0042]

loss

level

表示听损分类子网络的损失函数,具体表示为:

[0043][0044]

其中,oi表示softmax分类器对第i个听损程度的预测概率,n

l

表示听损程度的总分类个数,leveli表示第i个听损程度的真实概率,由听损程度分类等级转变而成:

[0045][0046]

式中level表示听损程度分类等级,由500hz、1khz、2khz和4khz的平均听阈损失avg

hl

计算得到,具体表示为:

[0047][0048]

式中ceil表示向下取整,level为1~n

l

之间的整数。

[0049]

与现有技术相比,本发明的有益效果是:

[0050]

1.本发明是基于听损分类的助听器语音质量自评价方法,相较于全参考的语音质量评价方法,不需要采集纯净的语音信号作为参考,简化了处理步骤,丰富了使用场景;

[0051]

2.本发明将卷积神经网络、结合注意力机制的循环神经网络、全连接层与softmax分类网络有机地结合成一个整体,充分利用卷积神经网络的特征挖掘能力、结合注意力机制的循环神经网络的时序建模能力和softmax网络的分类能力,提高了无参考质量评估网络的评价准确性;

[0052]

3.本发明在传统的lstm模型中融入了注意力机制,使循环单元能够从隐藏输出中筛选出丰富的有用信息;

[0053]

4.本发明采用多任务训练策略,以质量预测作为主任务,听损分类作为辅任务,通过权重因子调节主辅任务在质量评估网络中的重要程度;选取的辅任务与主任务在助听器质量评估方面具有较大的相关性,提升了助听器语音质量自评价的准确性。

附图说明

[0054]

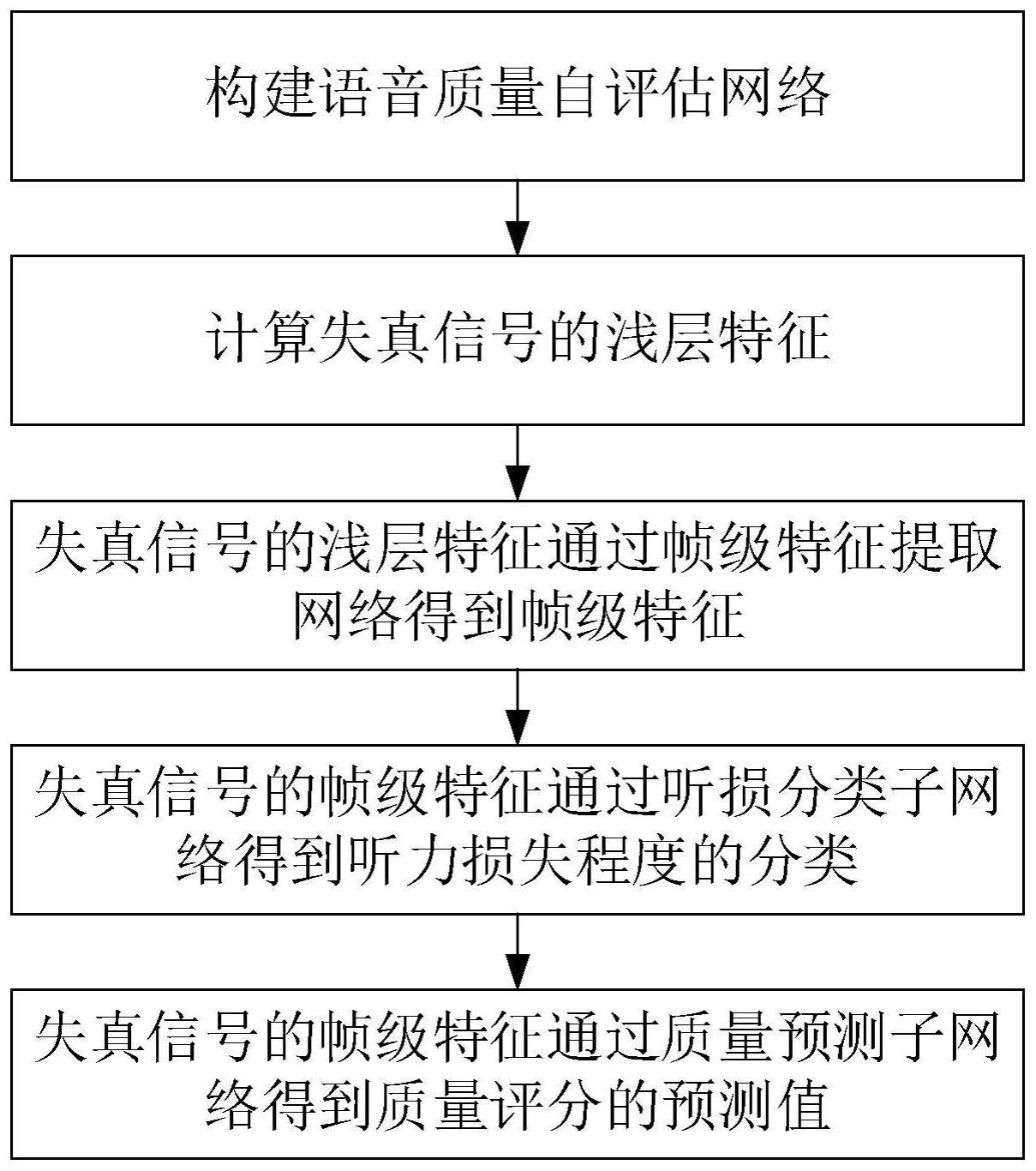

图1是本发明提供的基于听损分类的助听器语音质量自评价方法的流程图;

[0055]

图2是本发明提供的基于听损分类的助听器语音质量自评价方法训练集训练的流程图;

[0056]

图3是本发明实施例中所使用的帧级特征提取网络的流程图;

[0057]

图4是本发明实施例中所使用的听损分类子网络的流程图;

[0058]

图5是本发明实施例中语音经加噪、增强和听损条件处理的波形图;

[0059]

表1是发明实施例中经训练集训练后的网络与对比网络在测试集上的预测结果评估表。

具体实施方式

[0060]

以下结合附图和具体实施例对本发明作出的进一步详细说明。根据下面说明和权利要求书,本发明的优点和特征将更清楚。需说明的是,附图均采用非常简化的形式且均使用非精准的比例,仅用以方便、明晰地辅助说明本发明实施例的目的。

[0061]

实施例

[0062]

本发明提供了基于听损分类的助听器语音质量自评价方法,请参阅图1和图2,包括如下步骤:

[0063]

s1:构建包括帧级特征提取网络、听损分类子网络、质量预测子网络的助听器语音质量自评价网络;其中,帧级特征提取网络由四个二维卷积网络堆叠而成;听损分类子网络由一组经过批标准化后的全连接层和softmax层构成;质量预测子网络由循环神经网络、注意力机制层和一个经过激活的全连接层构成。

[0064]

s2:将待测语音的浅层特征输入至帧级特征提取网络中,基于助听器处理后信号计算浅层特征,利用帧级特征提取网络学习失真信号的深层表示,从而获得帧级特征;

[0065]

首先对待测语音分帧,本实施例设置采样率为16khz,帧长为320点,帧移为帧长的一半,假设失真信号的点数为l,则帧数其中表示向下取整,最终得到形如t

×

320的语音数据矩阵;

[0066]

待测语音分帧后计算其浅层特征,所述的基于助听器处理后信号计算浅层特征为信号的fbes特征,具体表示为:

[0067][0068]

式中s表示失真信号经分帧加窗后在在听觉频率尺度上的短时对数幅度谱,c,t,n分别为gammantone滤波器组的通道数c、帧数t、帧长n,其中,t表示的语音帧的标号,t表示的语音分帧后全部帧的个数;二者关系为t=0,1,2,

…

t;由于本实施例选用gammantone滤波器组是32通道的,因此得到的待测语音浅层特征的形状为t

×

32;

[0069]

帧级特征提取网络的结构如附图3所示,是一个由4组卷积网络组成的卷积神经网络,其中每组卷积网络依次包含一个二维卷积层,一个批标准化层和一个prelu激活函数层;各组二维卷积层的输出特征数依次为8、8、16、16,卷积核大小依次为[5,5]、[5,5]、[3,5]、[3,5],卷积步长依次为[1,1]、[1,2]、[1,2]、[1,2],填充宽度依次为[2,2]、[2,2]、[1,2]、[1,2];失真信号的浅层特征经卷积神经网络处理后,提取出了形如16

×

t

×

4的帧级特征。

[0070]

s3:将获得的帧级特征输入至听损分类子网络中,将形状重置后的帧级特征先进行全局平均得到段级特征,然后通过一组经过批标准化后的全连接层和softmax层,得到失真语音补偿前听力损失程度的分类情况;

[0071]

其中,具体包括以下步骤:

[0072]

s31:将卷积神经网络提取出的帧级特征先进行形状重置,生成形如t

×

64的特征,其中t为帧数t,再将形状重置后的帧级特征进行全局平均,得到形如1

×

64的段级特征;

[0073]

s32:将段级特征输入至听损分类子网络的两个全连接层:听损分类子网络的结构如附图4所示,由两个全连接层和一个softmax层堆叠而成,每个全连接层的输出都经过一个批标准化层,其中第一个批标准化层的输出经relu函数激活后送入第二个全连接层,第二个批标准化层的输出作为两个全连接层的最终输出被送入softmax层;段级特征经过两个全连接层的最终输出是长度为n

l

的向量,n

l

表示听损程度的总分类个数,在本实施例中n

l

=16;

[0074]

s33:将两个全连接层的最终输出送入softmax层:两个全连接层输出的是长度为n

l

的向量,经softmax层给出了失真语音补偿前听力损失程度的分类情况,具体表示为:

[0075][0076]

式中表示送入softmax层的语音特征,下标i表示听损程度分类的级别,i∈{1,2,...,n

l

},oi(z)表示针对输入的语音特征softmax层对每一个听损程度分类的预测概率。

[0077]

s34:待测语音的帧级特征同时输入至质量预测子网络:将形状重置后的帧级特征先通过结合自注意力机制的循环神经网络得到段级特征,这个段级特征再通过一个全连接层映射得到质量评分的预测值。

[0078]

s4:将获得的帧级特征同时输入至质量预测子网络中,得到质量评分的预测值,过程为:

[0079]

将形状重置后的帧级特征先通过结合自注意力机制的循环神经网络得到段级特征,这个段级特征再通过一个全连接层映射得到质量评分的预测值,其中质量预测子网络由循环神经网络、注意力机制层和一个经过激活的全连接层构成;

[0080]

具体包括如下步骤:

[0081]

s41:将卷积神经网络输出的帧级特征进行形状重置,生成形如t

×

64的帧级特征;

[0082]

s42:形状重置后的帧级特征送入结合注意力机制的循环神经网络得到段级特征:采用bilstm学习时序数据的双向依赖性,采用注意力机制补偿bilstm输出的隐层状态中可能存在的信息损失,其中bilstm的输入特征维数和隐层状态维数都设定为64,则输出特征的形如t

×

64,其中t为帧数t,注意力机制对bilstm双向输出的各时间步都计算经注意力权重向量加权后的隐层状态输出,以前向传播的第t个时间步为例,注意力机制对其的输出为:

[0083][0084]

式中,m表示当前时间步,为第i时间步的隐藏输出列向量,上标f表示正向计算,表示第i的时间步对当前时间步m的注意力权重向量,计算如下:

[0085][0086]

式中wa为可学习的权重矩阵,m为时间步的个数,上标t表示矩阵转置;最终结合注意力机制的循环神经网络输出的段级特征是一个长度为128点的向量;

[0087]

s43:结合注意力机制的循环神经网络输出的段级特征送入全连接层映射得到质量评分的预测值:用于质量评分映射的全连接层由128个输入节点,1个输出节点组成,段级特征通过该全连接层后经sigmoid函数激活后给出最终预测的质量分数。

[0088]

s5:助听器语音质量自评价网络利用助听器语音质量指标为标签的训练数据进行训练,损失函数由质量预测子网络和听损分类子网络的损失函数加权组合而成。

[0089]

本实施例所用的训练数据自voice bank corpus语音库中28个说话人(14男14女)说的11572个句子。这些语音以-5~15db间任一信噪比随机叠加了noisex-92噪声集15种噪声中的一种,每条含噪语音接着通过传统维纳滤波法、基于先验信噪比的维纳滤波法和一种多带谱减法中的一种增强算法进行降噪处理,最终将未处理的含噪语音以及分别通过三种增强算法处理后的降噪语音作为训练集的失真音频样本。训练集一共包含11572

×

4个样本,这些样本接着在随机的听力损失条件下计算了助听器语音质量指数(hasqi)作为训练标签。其中,构成听力损失条件的听力损失数据来自169名听障患者的338个患耳听力图,按照1997年who的听力损失程度分级表,正常听力损失的患耳有8个,轻度听力损失的患耳有18个,中度听力损失的患耳有103个,重度听力损失的患耳有128个,极重度听力损失的患耳有81个。

[0090]

训练过程中计算语音质量自评估网络的损失函数,所述语音质量自评估网络的损失函数由质量预测子网络和听损分类子网络的损失函数加权组合而成,权重因子β调节听损分类子网络在语音质量自评价网络中的重要性程度,在本实施例中β=0.2:

[0091]

loss=(1-β)loss

score

+βloss

level

[0092]

其中,loss

score

表示质量预测子网络的损失函数,具体表示为

[0093][0094]

loss

level

表示听损分类子网络的损失函数,具体表示为

[0095][0096]

其中,oi表示softmax分类器对第i个听损程度的预测概率,n

l

表示听损程度的总分类个数,leveli表示第i个听损程度的真实概率,由听损程度分类等级转变而成

[0097][0098]

式中level表示听损程度分类等级,由500hz、1khz、2khz和4khz的平均听阈损失avg

hl

计算得到,具体表示为

[0099]

[0100]

式中ceil表示向下取整,level为1~n

l

之间的整数。

[0101]

按照上述5个步骤训练本实施例所述网络,同时使用sqinet和sqinet-class作为对比网络,并用相同的训练数据进行训练。对比网路中的sqinet是在本发明的基础上去除听损分类子网络后的网络结构,即其仅由帧级特征提取网络和质量预测网络组成;sqinet-class是基于质量分类的sqinet,同样使用多任务训练策略,只是辅任务的训练目标为质量分类标签。

[0102]

本实施例所用的测试数据同样来自voice bank corpus语音库,采用语音库中剩余两个说话人(1男1女)说的824个句子进行构建。每个句子都使用被随机叠加了5~15db间任一信噪比的noisex-92噪声集中的一种噪声,然后采用了构建训练集时的3种语音增强算法中的一种或选择不增强语音对含噪语音进行处理。测试集一共包含824个样本,这些样本同样在随机的听力损失条件下计算了助听器语音质量指数(hasqi)作为真实值。此处,构成听力损失条件的听力损失数据来自于不同于训练集的7名听障患者的14个患耳听力图,按照1997年who的听力损失程度分级表,中度听力损失的患耳有2个,重度听力损失的患耳有10个,极重度听力损失的患耳有2个。

[0103]

为验证本发明的助听器语音质量自评价准确度,在上述测试集中,使用了所述放方法和两个对比网络对结果进行了预测,并计算各网络的预测值与真实值之间的差距。通过如下pearson相关系数(pcc)、均方根误差(rmse)和平均绝对误差(mae)这三个评估指标进行衡量,其中pcc描述两个变量之间的线性相关程度,计算式如下:

[0104][0105]

式中n为样本数,moso为客观评分,moss为主观评分,和分别为客观评分的平均值和主观评分的平均值;rmse和mae都描述两个变量间的误差情况,计算式如下:

[0106][0107][0108]

本实施例所述网络和对比网络在测试集上的预测准确度如附表1所示。

[0109][0110]

表1

[0111]

从表中可以看出,本发明所述方法在所有指标上都大幅优于对比网络,即本发明所述方法与助听器语音质量指标(hasqi)的线性相关程度最高,差值最小;且本发明的方法语音经加噪、增强和听损条件处理的波形图如图5所示,都能够说明本发明的助听器语音质

量自评估准确度更高。

[0112]

上述描述仅是对本发明较佳实施例的描述,并非对本发明范围的任何限定,本发明领域的普通技术人员根据上述揭示内容做的任何变更、修饰,均属于权利要求书的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1